सोशल मीडिया पर एक वीडियो तेजी से वायरल होता है जो चर्चा का विषय बना हुआ है। अमिताभ बच्चन समेत कई लोग इस पर अपनी चिंता जाहिर कर रहे हैं। दरअसल इसकी बड़ी वजह यह है कि यह एक डीपफेक वीडियो है जिसमें तकनीक के ज़रिये एक महिला को अभिनेत्री रश्मिका मंदाना की तरह दिखाने की कोशिश की गई। उसके बाद चारों तरफ प्रतिक्रियाओं का दौर चल ही रहा था कि कल बीते शाम इसी तरह का एक नया वीडियो सामने आता है। अभिनेत्री कैटरीना कैफ का भी एक डीपफेक वीडियो वायरल किया जाता है। उनकी आने वाली फिल्म के एक दृश्य को डीपफेक करके वायरल किया जा रहा है।एक के बाद एक अभिनेत्रियों के ऐसे वीडियो आना महिला सुरक्षा के लिए एक बड़ा चिंता का विषय है।

द क्विंट में प्रकाशित ख़बर के अनुसार पांच नवंबर को फिल्म अभिनेत्री रश्मिका मंदकाना की वीडियो वायरल होती है जिसमें असल में अभिनेत्री खुद है ही नहीं थी। जारा पटेल नाम की एक ब्रिटिश भारतीय महिला द्वारा उनके सोशल मीडिया पर पोस्ट किए गए वीडियो में अभिनेत्री मंदाना के चेहरे के साथ जोड़कर उसके साथ छेड़छाड़ की गई। भारतीय सूचना तकनीक मंत्री ने वीडियो को डीपफेक बताते हुए गलत “सूचना का बहुत अधिक हानिकारक रूप” कहा है। यह मामला जब सामने आया था जब ऑल्ट न्यूज़ के पत्रकार अभिषेक कुमार ने सबसे पहले बताया था कि अभिनेत्री का यह वीडियो एक डीपफेक वीडियो है। उन्होंने सोशल मीडिया एक्स पर पोस्ट किया था।

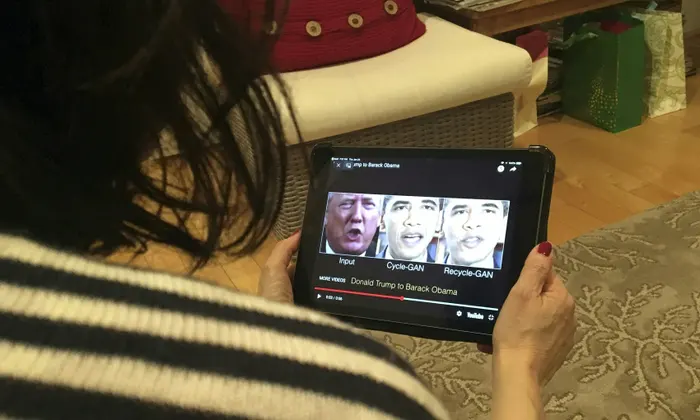

डीपफेक सामग्री को सबसे पहले 2014 में सिंथेटिक मीडिया कहा गया था। बाद में धीरे-धीरे जैसे इसकी लोकप्रियता बढ़ती गई 2017 में एक रेडिट यूज़र ने एक अश्लील वीडियो बनाने के लिए इसका इस्तेमाल किया था। वीडियो में मशहूर हस्तियों के चेहरे पोर्न कलाकारों के चेहरे पर बदल दिए गए थे।

इस घटना पर दुख जाहिर करते हुए अभिनेत्री रश्मिका ने कहा है, “यह निश्चित करना बहुत ज़रूरी है कि आगे से किसी के साथ ऐसा कुछ न हो।” अपने सोशल मीडिया एक्स हैंडल पर उन्होंने लिखा है, “वास्तव में यह बहुत डरावना है न सिर्फ मेरे लिए हम सबके के लिए जो तकनीक का इस्तेमाल कर रहे हैं।” उन्होंने आगे लिखा है, “एक औरत और एक अभिनेत्री होने के कारण मैं अपने परिवार, दोस्तों और शुभचिंतकों की शुक्रगुजार हूं जो मेरे लिए एक सपोर्ट सिस्टम की तरह खड़े हैं। लेकिन अगर ऐसा मेरे साथ तब होता जब मैं स्कूल या कॉलेज में होती तो सच में मैं नहीं जानती इसका कैसे सामना करती। इससे पहले की हममें से अधिक लोग इस तरह की पहचान की चोरी से प्रभावित हो हमें सामूहिक रूप से और तत्परता से इस पर ध्यान देने की आवश्यकता है।”

डीपफेक क्या है

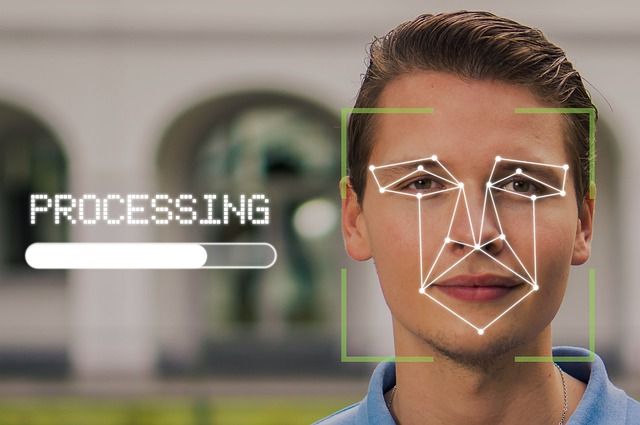

डीपफेक ऐसी तकनीक है जिसमें एआई का इस्तेमाल करके मल्टीमीडिया कंटेंट यानी तस्वीरों, ऑडियो और वीडियो में बदलाव किया जाता है। किसी भी व्यक्ति के चेहरे या शरीर को एक अलग व्यक्ति के चेहरे या शरीर के रूप में दिखाने के लिए संशोधित किया जाता है। यह नकली होने के बावजूद भी इतनी वास्तविक लगती है कि लोग बहुस आसानी से इसे पहचान नहीं पाते हैं। डेक्कन हेराल्ड में प्रकाशित जानकारी के मुताबिक़ डीपफेक सामग्री को सबसे पहले 2014 में सिंथेटिक मीडिया कहा गया था। बाद में धीरे-धीरे जैसे इसकी लोकप्रियता बढ़ती गई 2017 में एक रेडिट यूज़र ने एक अश्लील वीडियो बनाने के लिए इसका इस्तेमाल किया था। वीडियो में मशहूर हस्तियों के चेहरे पोर्न कलाकारों के चेहरे पर बदल दिए गए थे।

डीपफेक तकनीक कैसे काम करती है

डीपफेक तकनीक के तहत बदले गए वीडियो, ऑडियो या तस्वीर को बनाने में कुछ स्टेप लगते है। द गार्जियन में प्रकाशित लेख के मुताबिक़ ऐसे कंटेंट बनाने में एल्गोरिदम का इस्तेमाल किया जाता है। एनकोडर नामक एआई एल्गोरिदम के माध्यम से दो लोगों के चेहरे के बीच समानता ढूढ़ी जाती है और अन्य इमेज संपादित की जाती है। दूसरे एल्गोरिदम डिकोडर से क्रॉमप्रेस्ड तस्वीरों से चेहरे को दोबारा प्राप्त करना सिखाया जाता है। एनकोडर और डिकोडर के अलग-अलग कमांड से काम किया जाता है। डीपफेक बनाने का एक अन्य तरीका जेरेरिटिक एडवरसैरियल नेटवर्क बनाते हैं जिसे जीएएन कहा जाता है। डीपफेक में कई स्तर पर फीडबैक के सहारे गलतियों को सुधार करके उसे बेहतर बनाया जाता है।

मुख्य तौर पर महिलाओं को बनाया जा रहा है निशाना

समय के साथ-साथ डीपफेक का विस्तार भी हो रहा है। तकनीक में बदलाव और बढ़ोत्तरी के साथ यह और बेहतर होती जा रही है। इस तरह के बदलाव एक तरफ जहां चौकाने वाले है साथ ही दूसरी और ऐसे डीपफेक बनाए जा रहे है जिनका आसानी से पता लगाना असंभव होता जा रहा है। कई रिपोर्ट के अनुसार इस तकनीक से शुरू में अश्लील कंटेंट बनाया गया था। पोर्नोग्राफी में इसका इस्तेमाल किया गया था। आज नेता, अभिनेता, अभिनेत्री या अन्य मशहूर हस्तियों के डीपफेक वीडियो बनाए जा रहे हैं जिसमें मनोरंजन से लेकर राजनीतिक मकसद तक शामिल है।

साल 2018 में पत्रकार राणा अय्यूब को निशाना बनाते हुए डीपफेक पोर्नोग्राफी कैंपेन चलाया गया था। जो इतना बढ़ गया था कि उनके इसकी वजह से उन्हें अस्पताल तक में भर्ती होना पड़ा था। महिला पहलवानों के जंतर-मंतर पर यौन हिंसा के ख़िलाफ़ हो रहे आंदोलन में भी डीपफेक तस्वीरों का इस्तेमाल किया गया। इसी तरह यूक्रेन की प्रथम महिला ओलोना ज़ेलेंस्का के डीपफेक जारी किए गए। उस समय जारी इस तरह की तस्वीर और वीडियो का मकसद पूरी तरह राजनीतिक था। रूस और यूक्रेन युद्ध के दौरान भी कई डीपफेक वीडियो सामने आए। अमेरिका में भी चुनाव के दौरान अलग-अलग डीपफेक सामने आए थे।

एक रिपोर्ट के मुताबिक़ 90 फीसदी डीपफेक की विक्टिम महिलाएं हैं, जिनके कारण बदला, बदनाम करना आदि है। समय के साथ-साथ ये बहुत घातक भी होते जा रहे हैं लेकिन सवाल साथ में यह है कि सोशल मीडिया कंपनी और देशों में इस मुद्दे को उस गंभीरता से संबोधित नहीं किया जा रहा जितने की इस पर आवश्यकता है। साथ ही यह सवाल भी बनता है कि ये अभियान कैसे इतने प्रभावी होते जा रहे हैं। अक्सर मौजूदा मीडिया एल्गोरिदम और मनोविज्ञान इसमें भूमिका निभाते हैं।

सेंसिटी एआई की रिपोर्ट द स्टेट ऑफ डीपफेक 2019 लैडस्कैप, थ्रेट्स एंड इम्पैक्ट में पाया गया है कि 96 फीसदी डीपफैक गैर-समहति वाले सेक्सुअल डीपफेक थे और उनमे से 99 फीसदी महिलाओं पर बनाए गए थे। डीपफेक लैंगिक हिंसा का एक नया रूप है जिसमें आर्टिफिशियल इंटेलिजेंस तकनीक के सहारे महिलाओं की स्वायत्तता को खत्म किया जाता है। उन्हें अपमानित और उनका शोषण किया जाता है। डीपफेक के ज़रिये महिलाओं को निशाने बनाने की ख़बरे अलग-अलग देशों में देखने को मिल रही है। अमेरिका और दक्षिण कोरिया में महिला हस्तियां मुख्य रूप से सेक्सुअल डीपफेक का टार्गेट है। दक्षिण कोरिया में ये वीडियो इतने प्रचलित हो गए थे कि वहां के लोगों ने सरकार से इस मुद्दे के समाधान के लिए कदम उठाने तक का आह्वान किया था। इस तरह की घटनाओं में महिलाओं के ख़िलाफ़ बढ़ते मामलों को देखते हुए कई देशों में इससे बचने के लिए कदम उठाए है और कानून बनाए है।

क्या है भारतीय कानून में प्रावधान

हिंदुस्तान टाइम्स में प्रकाशित हाल में हुए एक सर्वे के अनुसार भारत में 94 फीसदी डीपफेक एडल्ट कंटेंट मनोरंजन इंडस्ट्री की हस्तियों को टार्गेट करके बनाया जाता है। डीपफेक वीडियो के विस्तार लगातार बढ़ता जा रहा है। भारत में भी ऐसे मामले लगातार बढ़ रहे हैं जिस वजह से एआई तकनीक को रेग्युलेट करना बहुत ज़रूरी है। भारत में डीपफेक के ख़िलाफ़ कानून में इस तरह के अपराध के मामले में किसी व्यक्ति की इमेज को बड़े स्तर पर मीडिया में कवर करना भी शामिल है।

आईटी ऐक्ट 2000 के तहत धारा 66ई के तहत उसकी निजता का हनन करने का उल्लघंन है। इस अपराध के लिए तीन साल की सजा और 2 लाख से ऊपर के जुर्माने का प्रावधान है। इसी तरह के संदर्भ में आईटी मंत्री राजीव चंद्रशेखर ने अप्रैल 2023 में कहा था कि यह प्लेटफॉर्मों के लिए यह एक कानूनी दायित्व है कि वे सुनिश्चित करें कि किसी भी यूज़र्स द्वारा कोई गलत जानकारी पोस्ट न की जाए और यह सुनिश्चित करें कि जब किसी यूज़र्स या सरकार द्वारा रिपोर्ट की जाए तो गलत सूचना को 36 घंटों में हटा दिया जाए।

अभिनेत्री रश्मिका ने कहा है, “यह निश्चित करना बहुत ज़रूरी है कि आगे से किसी के साथ ऐसा कुछ न हो। अपने सोशल मीडिया एक्स हैंडल पर उन्होंने लिखा है, वास्तव में यह बहुत डरावना है न सिर्फ मेरे लिए हम सबके के लिए जो तकनीक का इस्तेमाल कर रहे है।

मीडिया को बरतनी होगी सावधानी

एक अध्ययन में पाया गया है डीपफेक पर आधारित मीडिया रिपोर्ट में मुख्य रूप से डीपफेक के नकारात्मक इस्तेमाल पर ध्यान केंद्रित किया गया है, न कि सेक्सुअल डीपफेक के गैर-सहमित निर्माण से होने वाले नकुसान पर जो इस तरह के वायरल का सबसे आम रूप है। अध्ययन के मुताबिक़ मीडिया ने इस समस्या को और बढ़ाने और प्रचारित करने का काम किया है। ऐसे में पारंपरिक मीडिया की जिम्मेदारी बनती है कि वह ऐसी घटनाओं का बिना विवरण दिए और बिना लिंक दिए जानकारी प्रसार कर सकता है न की अपने ख़बर देने में इस तरह के कंटेंट को विस्तारित करने में और मददगार साबित है। हाल के मामलों में अगर हम भारतीय मेनस्ट्रीम मीडिया की रिपोर्टिंग देखे तो वहां इस तरह की सावधानी की भरपूर कमी देखने को मिली है।

आर्टिफिशल इंटेलिजेंस का प्रभाव आम जीवन पर लगातार बढ़ता जा रहा है इसलिए इसको रेग्युलेट करना समय की सबसे बड़ी आवश्यकता है। हमें यह नहीं भूलना चाहिए एआई तकनीक भी मनुष्यों द्वारा निर्मित की गई है जो पक्षपाती, पूर्वाग्रहों को बढ़ावा देने वाले हो सकते हैं। इस प्रकार यह असमानता और भेदभाव करने के लिए प्रेरित कर सकते है। एआई तकनीक डेटा विश्लेषण आधारित सिस्टम के तहत काम करता है जिसके लिए डेटा लीक ना हो यह सुनिश्चित करना ज़रूरी है। एआई तकनीक के द्वारा होने वाले अपराध बहुत गहरे मुद्दे बनते जा रहे हैं जो केवल गलत तस्वीर साझा करने या गलती से गलत चीज़ पर भरोसा करने तक सीमित नहीं है।